先週

・EdgeTPUを用いる事でリアルタイム認識可能なフレームレートで動作させる事が可能となった。(約7fps)

RaspberryPiとAcceleratorのUSBタイプが異なるので同じタイプとなれば、さらに高速にできると考えられる

・現在のモデルでは10mで66%、20mで12%で人と認識している。

・人を認識するとブザーがなるように既存のプログラムを改良した。

今週、来週の予定

・PasPiやブレッドボードをパッケージングする。

・データを収集し学習データ、モデルを作成する。

先週

・EdgeTPUを用いる事でリアルタイム認識可能なフレームレートで動作させる事が可能となった。(約7fps)

RaspberryPiとAcceleratorのUSBタイプが異なるので同じタイプとなれば、さらに高速にできると考えられる

・現在のモデルでは10mで66%、20mで12%で人と認識している。

・人を認識するとブザーがなるように既存のプログラムを改良した。

今週、来週の予定

・PasPiやブレッドボードをパッケージングする。

・データを収集し学習データ、モデルを作成する。

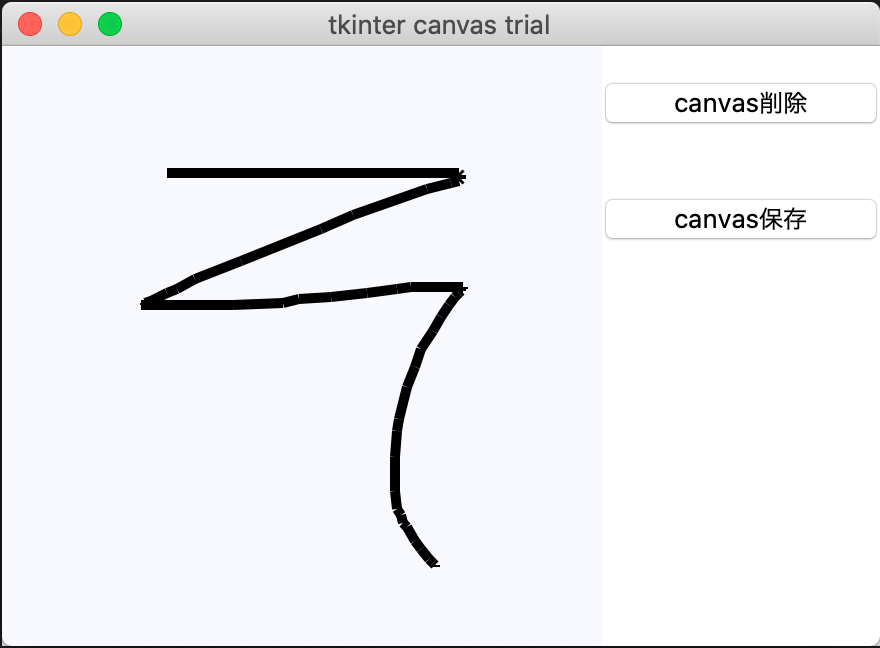

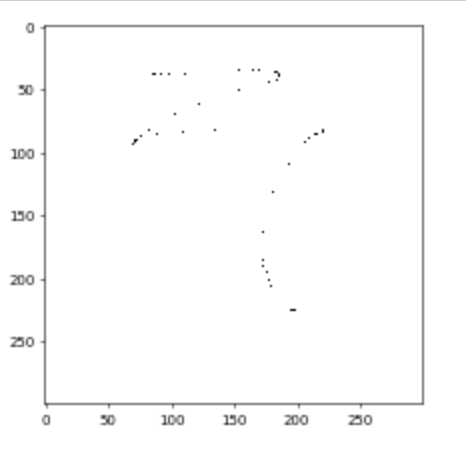

pytorchでVGG16 fine tuning用のコード作成。

10人分の筆跡のデータで学習を行ったが、間違えた前処理をしてしまったので、作り直す

detectron2(https://github.com/facebookresearch/detectron2)が面白そうなので調査中。

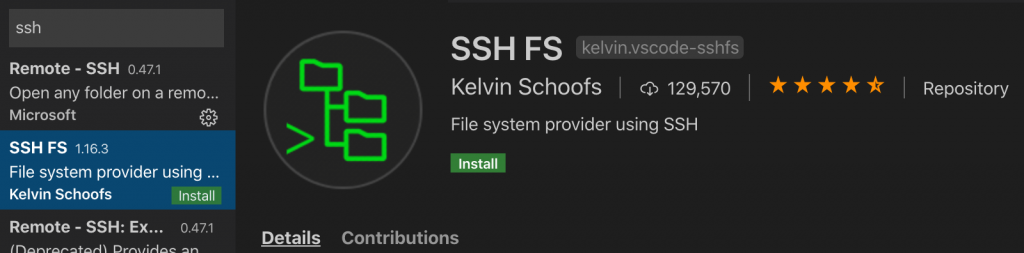

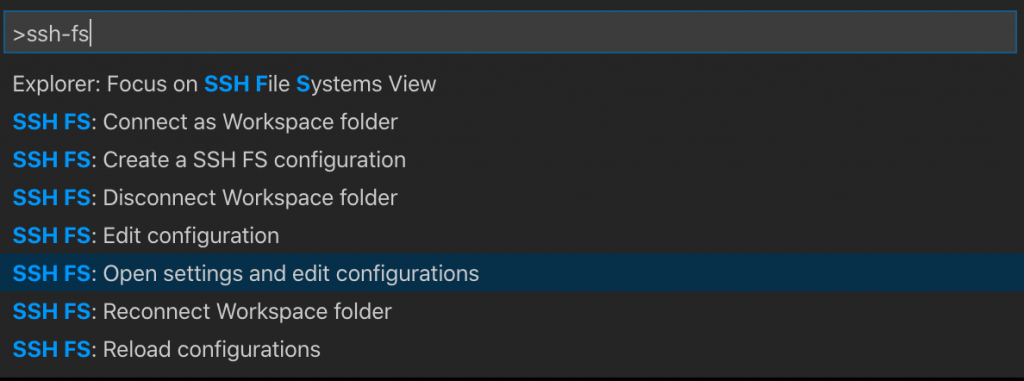

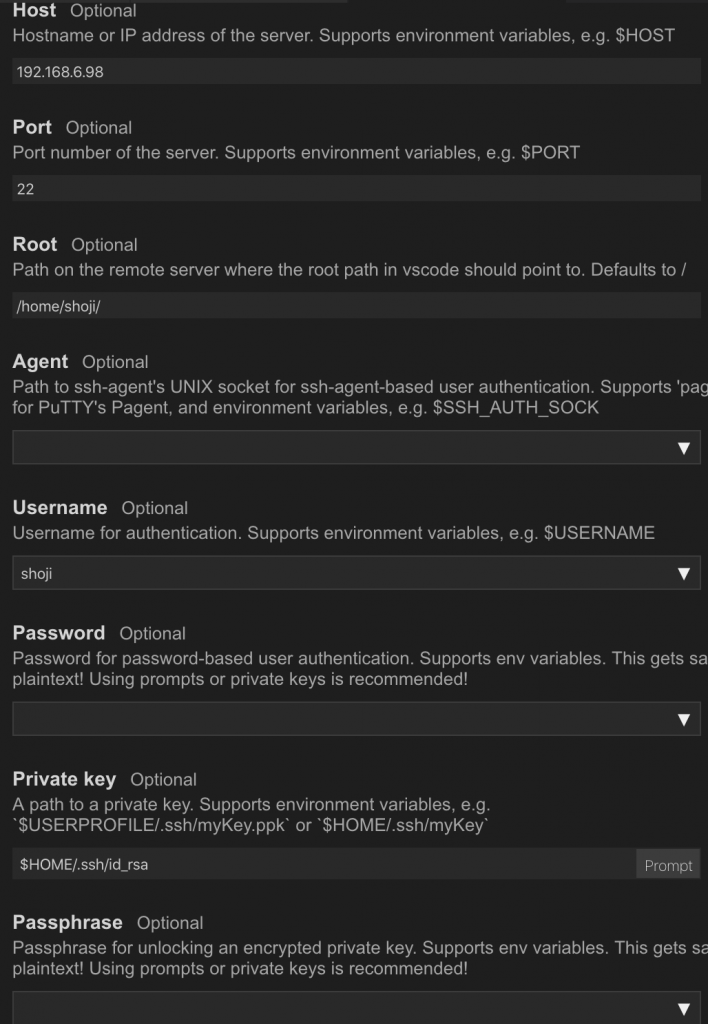

dockerコンテナに、クライアントpcから直接SSH接続できる方法を調べたが、docker とnetworkどちらの知識も足りず挫折。

jetson nanoで動かせる深層学習モデルの調査

財前:商品のトリミングを研究のキーポイントとする。現場でいくつかの商品を手に取る写真を取得し、商品の切り出しアイディアを考える。ソフトでするか、ハード(レンズの焦点距離固定か)を再考する。眼の不自由の人のプライドを考えて手法を考案する。

水戸:Dlibを使用し、顔の向きが検出できた。顔の方向ベクトルと瞳の座標を組み合わせて、視線位置を検出するアルゴリズムの作成を行う予定。投稿にフローチャットを追加してください。

五十君:日本に売られている商品名を単語分散表現で表す場合、いっぱんてきな言葉の単語表現との差があれば、商品名を単語分散表現のマップを作成する。

白石:機械学習VSMに入力するためのデータセット(NPZファイル)を画像から作成する。完成次第連絡。

二石:偏光フィルムでQRCodeを作成し、日光、夜間での検出実験を行う、結果次第で次へ進む。

北原:lipNetの学習データセットの作り方が分かったので、言葉数は日本語の50音を網羅したセットを用意する、話者は20名を目標とする。オリジナルLipNetを一回動かす!

DL-Boxにdocker+nvidia-docker2を導入したい。

メリット、コンテナごとにCUDAのバージョンを設定できるので、現状の環境を壊さずに様々なバージョンの機械学習用の環境構築ができる。

tmuxチートシート

https://qiita.com/nmrmsys/items/03f97f5eabec18a3a18b

#インストール用のスクリプト

$ vim .profile

export PYENV_ROOT="$HOME/.pyenv"

if [ -x "$PYENV_ROOT/bin/pyenv" ] ; then

export PATH="$PYENV_ROOT/bin:$PATH"

. <(pyenv init -)

[ -d "$PYENV_ROOT/plugins/pyenv-virtualenv" ] && . <(pyenv virtualenv-init -)

else

install_pyenv(){

… Continue Reading ››