・前照灯をつけた状態とつけていない状況で5~20mで距離を変えて動画と写真を撮影。

・RaspberryPiではYOLO3が動かなかったので、精度は落ちるが軽くて高速なTiny-YOLO3を実装し、動かした。しかし1~2fps。

・現在、EDGE TPUを試している。

「研究相談」カテゴリーアーカイブ

研究に関する相談事項

今週の進捗(仮屋)

進捗

- GPの学習:芹川先生にGPの参考書を貸して頂いたので、それを用いて学習を進めています。

- 修士論文の作成:まずは原理を中心に研究をまとめています。年内完成を目標として論文作成中です。(約20ページ作成)

予定

- パラメータ最適化手法の考案

- 実験

- 修士論文の作成

- 英語学習(今年度中に再度TOEIC受験? 目標は115点UPの900点)

今週の進捗(ZHU)

今週の進捗

- ReIDの理論知識とkivyの使用をさらに学ぶ。

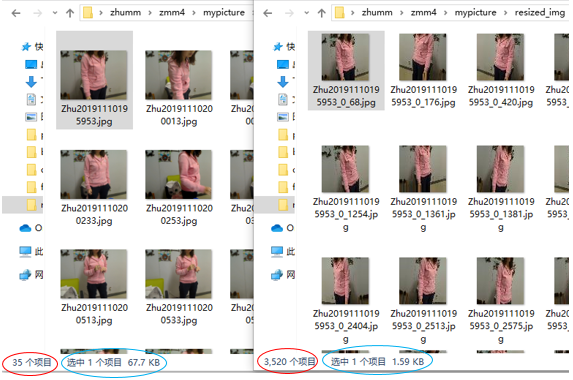

- 実験の必要性のため、今週は画像処理の基本動作、例えば画像の増強とサイズの変化を行った。

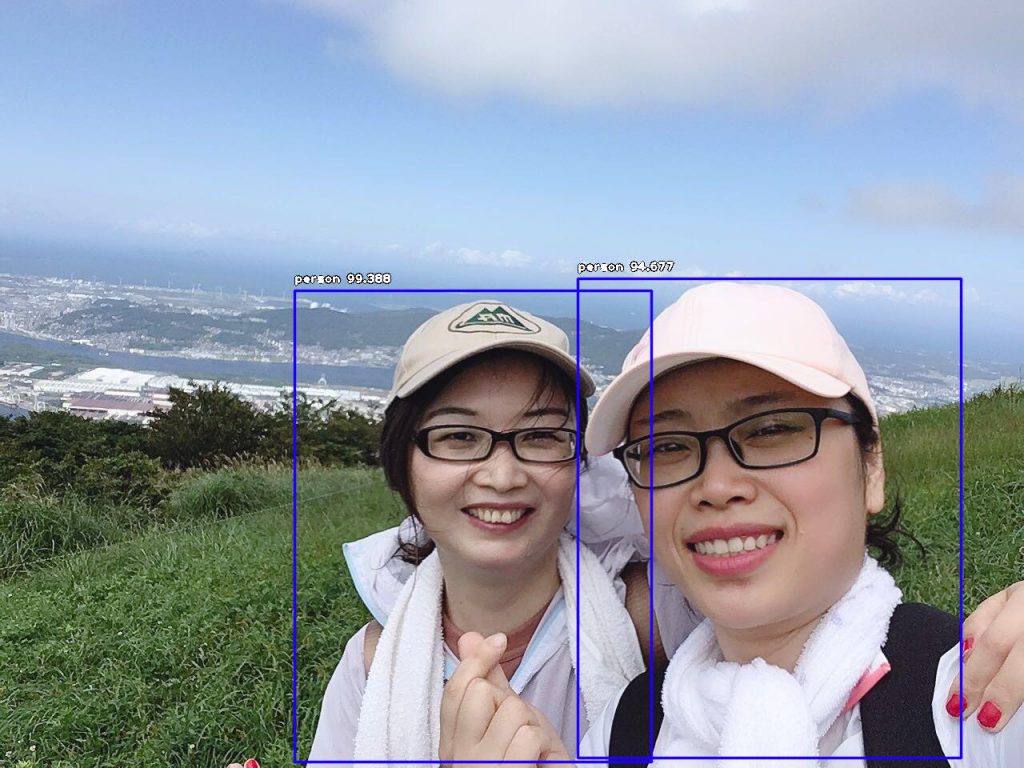

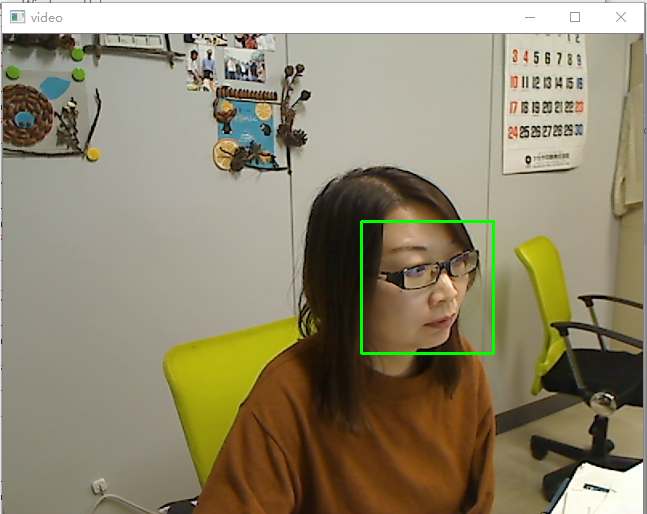

- 特定の画像の歩行者検出と、ビデオ内の顔のリアルタイム検出を実現します。

-

図2 画像の中で行人検出 -

図3 ビデオ内の顔の検出

- 歩行者の再識別の研究における重要なステップとして、リアルタイムのビデオ取得に基づいて、次のステップは、ビデオ内の歩行者のリアルタイム検出の実現を試みることです。

M1ゼミ

金當:アンドロイドスマホでカメラ機能を実装したので、今週はプログラムで画面輝度調整できるようにする。

井上:先行研究調査→webカメラだけで熱源を感知する研究はなかったので、基礎実験を行う。TOEIC650超えを狙う。

庄司:色々試してください、成功した場合記録を残るように!

今週の進捗(金當)

進捗

- Javaの入門書を半分まで読了

- カメラと連携しカメラアプリを作成

課題

- 取得した画像に処理を加える

- Javaの入門書を読み終える

- インターンシップに向けESの作成

B4ゼミ

財前:動く背景の除去を優先し、オプティカルフローやシフトなどのアルゴリズムからヒントを得てください。

五十君:fastTextの学習用データの構成仕方を確認し、一つのお店の商品名モデルを構成する。

水戸:目線マウスにするため、手を使うのがよろしくないので、顔ののパーツに機能をつける。ただし、目線を使うと目による情報収集に支障が出ますので、カーソルの動きは顔の向きでコントロールした方が良いと思われる。目の瞬きなどをクリックなどのアクションに割り当てる。

二石:偏光板の光に対する透過率と偏光率が定義されているので、これは人間の視認性と機械の可視性の折り合いがつくものに選べば、現存の交通標識適用可能との結論に持っていきたい。

白石:NPZファイルの構成が正しくない可能性があるので、動くサンプルをもう一度中身について解析し、エラーの原因を見つける。

北原:データの前処理が時間がかかり、処理待ち状態です。DL-BOXがCUDA9.0にアップデータしたので、使用可能かを確認すること。

今週の進捗(水戸)

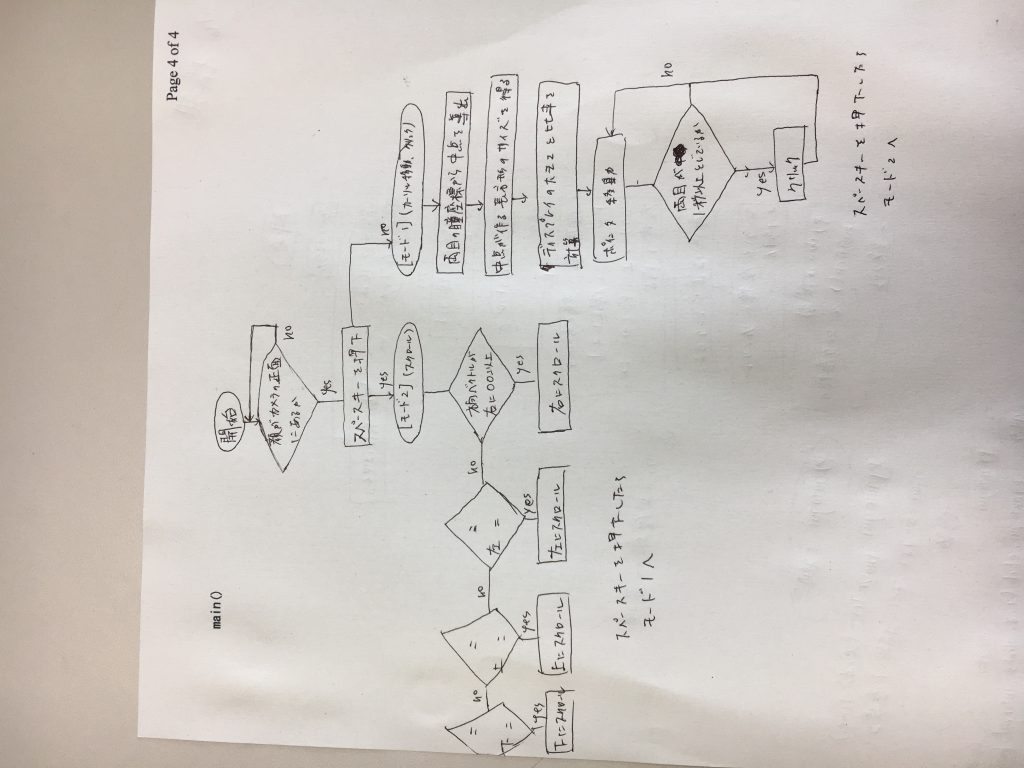

関数pyautogui.moveTo()により指定した座標までカーソルを持っていけることを確認した。次にシステム構成を考案した。先週は顔の方向ベクトルと黒目の位置により視点を定める方針にしていたが、もっと簡易的なシステムを作り上げたのち処理の複雑化をしたほうが効率的だと考えた。カーソル移動とスクロールでモード分けする予定です。

簡易的なシステムの条件を以下とする。

・カメラの位置はディスプレイの中心

・被験者はカメラの正面に立つ。ディスプレイ表示で正面に来るよう指示

・モード変更はスペースキーで行う

[カーソル移動、クリック]

・顔の向きはカメラと正対

・左右の黒目の座標を結んだ線分の中点を基準点とし、画面の左右上下端を見た時の座標で長方形ができるはずなのでディスプレイの大きさとの比率でカーソルの移動量を定める

・クリック動作は両目を1秒以上閉じたときとする。動作時にクリック音をスピーカー出力する。

[スクロール]

・顔の方向ベクトルの計算によりある値より大きくなるとその方向にスクロール

・目線情報はスクロールの際の材料にしない。

※カーソル移動について、斜視の人でない限り左右の瞳は同じ動きをするのでどちらか一方の瞳を用いてカーソルの移動量を計算する方法も検討する。

※中点の出し方

{(右の瞳の座標)+(左の瞳の座標)} / 2.0

今週の進捗(五十君)

テーマ「文字認識を用いた買い忘れ防止案」

今週の進捗

・fastTextの学習済みモデルによる類語抽出を試してみたが、食品以外にもたくさんの言葉が学習されているため、1単語に対しての類語抽出に約1分30秒ほどかかり、類語も食品とは関係ないものばかり抽出されました。

研究相談

①

http://tech.wonderpla.net/entry/2017/10/10/110000

https://qiita.com/kaka__non/items/0c5efaaa61cc1c4a553b

以上のサイトを参考にして、例えばお米の品種について学習させようとして学習データを作るとすると、(_label_1 = お米)

「_label_1,コシヒカリ ひのひかり あきたこまち ・・・」

「_label_1,あきたこまち ひのひかり コシヒカリ ・・・」

「_label_1,ひのひかり コシヒカリ あきたこまち ・・・」

とこんな感じで、品種名を入れ替えたテキストをいくつも用意すればいいのかと考えましたが、これは学習データとして適しているのでしょうか?

今週の進捗(北原)

テーマ:機械学習を用いた読唇精度の向上

githubにあるLipNetのコードを動かそうとした.

https://github.com/rizkiarm/LipNet:知識不足で実装できず

https://github.com/sailordiary/LipNet-PyTorch:Macでは動いたが1epochが17日となったため、DL-BOXで動かそうとしたがCUDA8がPytorch1以上に対応しておらず断念。

https://github.com/osalinasv/lipnet:tensorflow1.1なのでDL-BOXでも動かせそう。前処理に48時間くらいかかりそうなので待ってます。(11/11の深夜に始めた)

(追記)CUDA9になってました

今週の進捗(ZHU)

今週の進捗

- 歩行者の再識別(ReID)-Deep learning person re-identification in PyTorch, 異なるデータセットで個別にトレーニングとテストを行う(s- dukemtmcreid /-t- market1501)。

- 張先生の指導の下、実験の別の部分が始まりました:

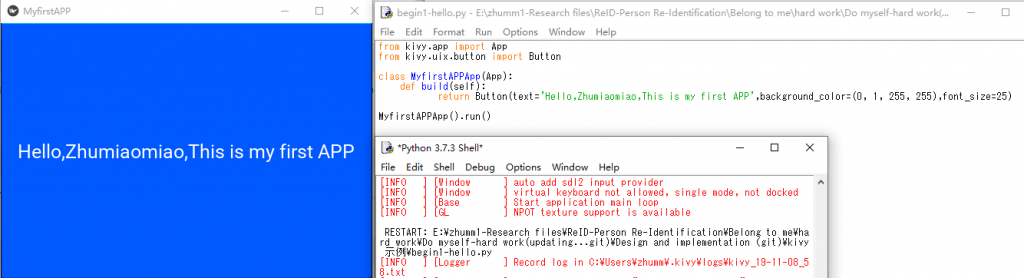

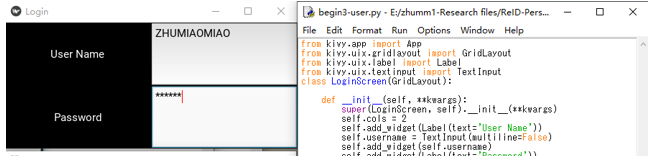

- (1)環境の構築を実行し、簡単なゲームアプリを実装することにより、開発プロセスを一般的に理解します(図 1、2、3)。

- (2)kivyとpygameを使用して、カメラから撮影した写真を表示します(図 4、5)。