今週の進捗

- 自己分析

- 模擬エントリーシートの作成

- 研究テーマの調査

→東京大学の研究室の研究内容を拝見

http://www.hal.t.u-tokyo.ac.jp/lab/ja/research_shinryoiki.xhtml

→画像計測・超解像をキーワードに論文検索

https://ci.nii.ac.jp

今後の課題

- 企業研究・業界研究

- 研究テーマの調査←11月前半までに

- TOEICの勉強←12月の試験で680点突破を目標

研究に関する相談事項

財前:研究ポイント1:商品を取る際の指をマーカーに、商品の切り出しを行う。ポイント2:機械学習を実行する環境を整える。VGG16での商品識別の精度を試すと同時に、手荷物商品の切り出す作業を重点に行う。まずは背景除去に関する文献検索。

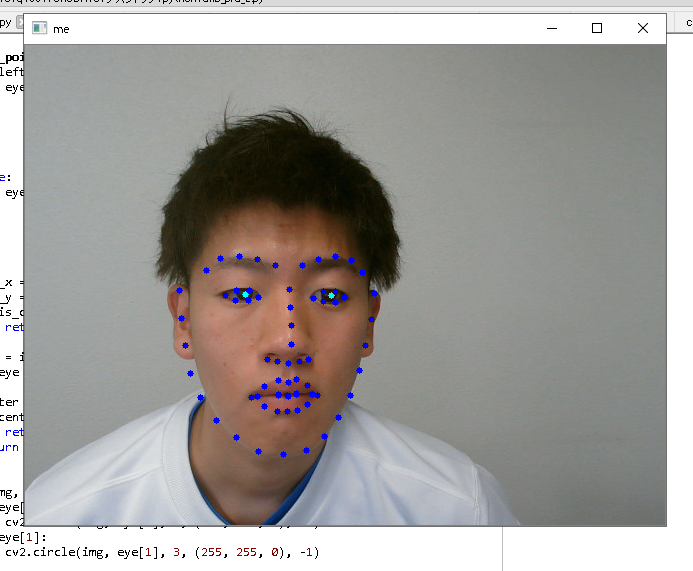

水戸:Dlibで検出した瞳の中心の動きを正しき判断できるかを試す。

二石:OpenCVのQrCodedetectorの扱い方、注意点を検索する。適用QRコード画像の状態を確認する。

北原:LipNetでの学習データの作成を専念。

五十君:fastText環境構築中、今週中に完成。その後、研究に入る。

白石:SVMのデモプログラムを動かした。今週は花の画像に適用する。 400枚中300枚を学習に使い、残りはテストデータとして使用する。

テーマ「アイトラッキングを利用したマウス操作簡易化」

ハフ変換を行う関数HoughCircles()のパロメータを変化させると顔全体の静止画像から瞳部分の抽出をすることができた(図1)。次にwebカメラから取得した映像から同様にハフ変換で瞳部分の抽出を行おうと試みたが動作しなかった。原因は、ハフ変換は処理に時間がかかるためフレームレートと同期せずに処理が行われなかったためだと推測した。

そこで異なる方法として、機械学習ライブラリdlibにある輪郭や瞳の識別器を用いて瞳の抽出を行おうと考えた。識別器によってwebカメラの映像から瞳の中心を抽出できることが確認できた(図2)。

今後は、左右の瞳の中心座標を取得してそれらを結んだ線分の中点を基準としてカーソル位置と一致させるようにプログラムを組む予定です。

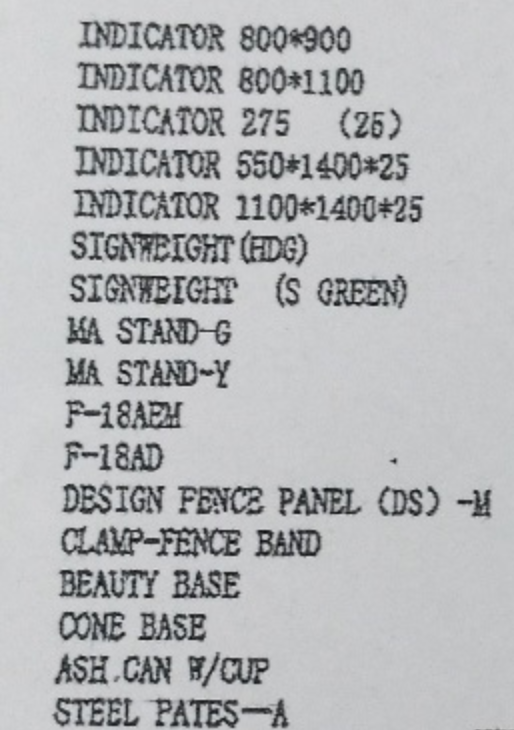

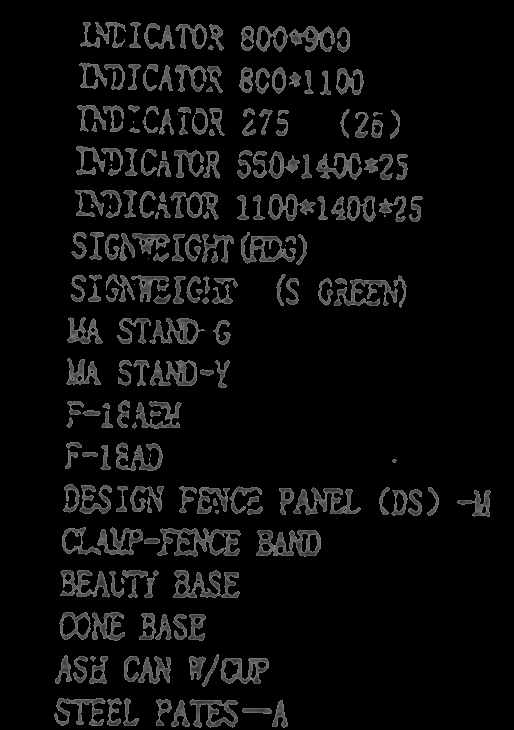

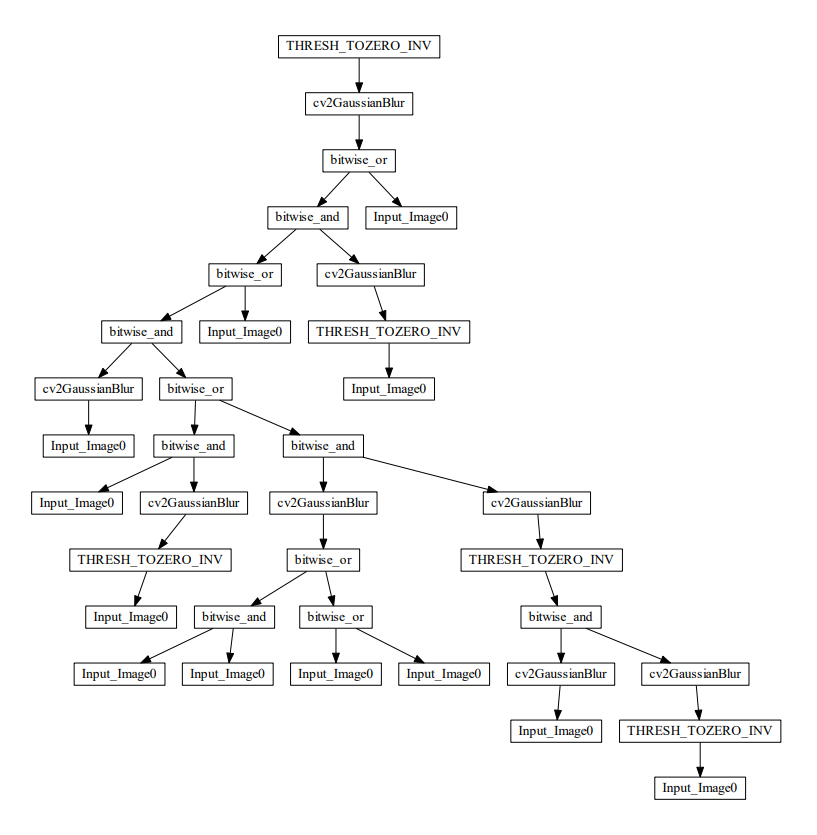

仮屋:OCR認識する前の画像フィルタリングの評価関数をレーベンシュタイン距離で行った。精度向上が認められた。

赤瀬:Kerasの設定を行う。CUDAバージョンアップに伴い、調整が必要。

中尾:OpenCVとDlibで顔パーツの検出、瞳の検出ができた。LED点灯させる装置の製作に入る。

藤島:車内での車外画像取得したが、画質がよろしくないので、車外での画像取得に試みる。

赤外線照射機を用いて撮影をおこなった。

50m先の人物の認識は周りの影響もあり最初から取り組むには現実的ではないと考えた。

60キロで走行時でも停止できるように50m先の人を認識させることを目標としていたが、現実的な30〜40m先の人物の認識から行おうと思う。

評価関数にレーベンシュタイン距離を適用したプログラムを実装・実行した。図4・図5にそれぞれ図1・図2を用いた場合の文字認識結果を示す。図4・図5のLev_valueは各文字列の認識結果と目標文字列とのレーベンシュタイン距離の合計値である。フィルターを使用しない場合のLev_valueが11.45であるのに対して、最優秀個体のフィルターを用いた場合は3.84と、約66%の改善が認められた。

今週の進捗

金當:アンドロイドアプリを作成するための学習、取り敢えずJAVAで作成し、画像処理デモを一個作る。

井上:英語の学習を強化。VibraImageで不審者の検出に関する論文を閲覧。CNNの勉強を継続中。研究テーマ:もう少し検討する。

梶岡:顔画像から、飲酒の有無を判断する基礎実験を行う。

〇今週の進捗

〇今後の課題