テーマ「アイトラッキングを利用したマウス操作簡易化」

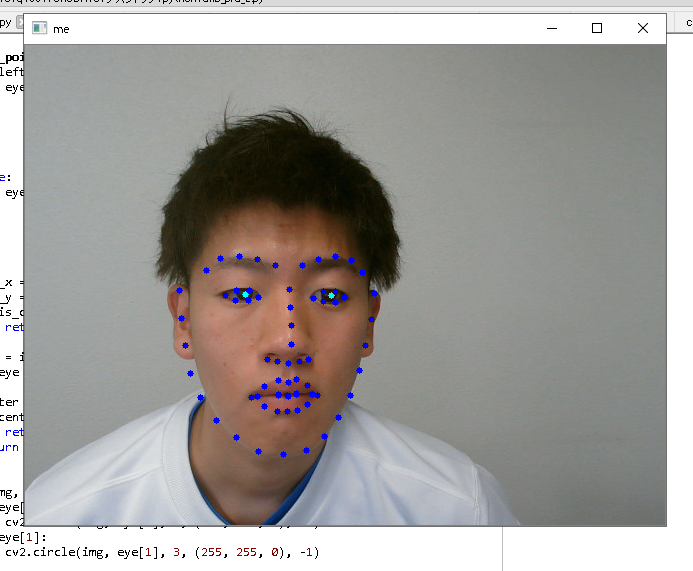

ハフ変換を行う関数HoughCircles()のパロメータを変化させると顔全体の静止画像から瞳部分の抽出をすることができた(図1)。次にwebカメラから取得した映像から同様にハフ変換で瞳部分の抽出を行おうと試みたが動作しなかった。原因は、ハフ変換は処理に時間がかかるためフレームレートと同期せずに処理が行われなかったためだと推測した。

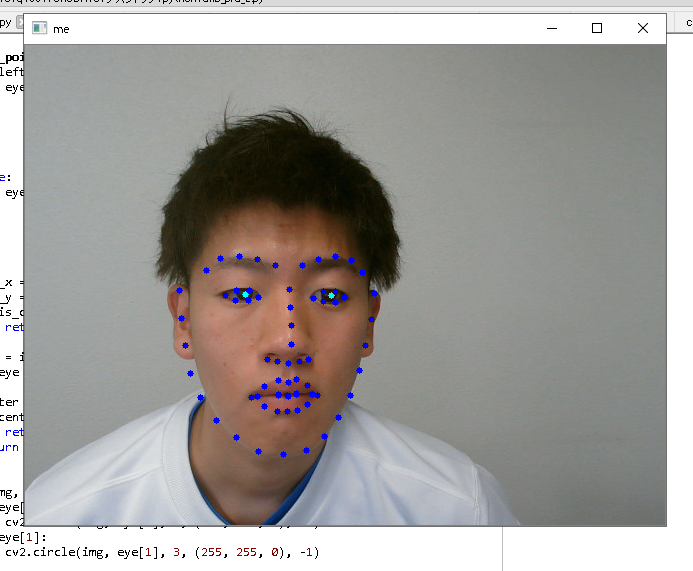

そこで異なる方法として、機械学習ライブラリdlibにある輪郭や瞳の識別器を用いて瞳の抽出を行おうと考えた。識別器によってwebカメラの映像から瞳の中心を抽出できることが確認できた(図2)。

今後は、左右の瞳の中心座標を取得してそれらを結んだ線分の中点を基準としてカーソル位置と一致させるようにプログラムを組む予定です。

図1 顔全体の画像からハフ変換で

図1 顔全体の画像からハフ変換で

瞳部分のみをマークした結果

図2 dlibの識別器を利用して特徴点をマークしたもの。

図2 dlibの識別器を利用して特徴点をマークしたもの。

瞳の中心を緑でマークしている。

自分の研究の段階は大きく分けて2つと改めて認識した

1、画像から判別する物体を検出

2、検出した物体を機械学習で判別

①親指に指サックなどを付け、それをCascadeClassifier関数を使い指サックを検出し、持っている商品までをトリミング・・・検出するためのxmlファイルの作成法を勉強中

②VGG16を用いた転移学習による判別

anacondaの仮想環境をつくりtensorflowなどの必要な物をインストールした

windowsの環境を構築した際jupyternotebookが動作しなかったためhttps://kazusa-pg.com/jupyter-notebook-use-virtual-env-kernel/を行い動作するよう設定した

転移学習を試行中

仮屋:OCR認識する前の画像フィルタリングの評価関数をレーベンシュタイン距離で行った。精度向上が認められた。

赤瀬:Kerasの設定を行う。CUDAバージョンアップに伴い、調整が必要。

中尾:OpenCVとDlibで顔パーツの検出、瞳の検出ができた。LED点灯させる装置の製作に入る。

藤島:車内での車外画像取得したが、画質がよろしくないので、車外での画像取得に試みる。

テーマ「文字認識を用いた買い忘れ防止案」

今週の進捗

・買い物前に登録した商品名とレシートから読み取った商品名のマッチングのため、レシートから読み取った商品名から類語を抽出し、抽出された言葉と登録した商品名が合致していれば「この商品は購入した」と認識させるようにしたいと考えた。そのために、自然言語用の学習モデルについて調べ、fastTextが良さそうだと思い、fastTextをインストールしようとしたが、fastTextをインストールする前にMecab,Cygwinなどをインストールする必要があったので、現在はそれらのインストールに時間を取られています。

https://qiita.com/yakipudding/items/e798614ca833d264abf3

今後の課題

・fastTextで上記のことができそうなのであれば、fastTextの学習用データをどうするのか考える。

赤外線照射機を用いて撮影をおこなった。

50m先の人物の認識は周りの影響もあり最初から取り組むには現実的ではないと考えた。

60キロで走行時でも停止できるように50m先の人を認識させることを目標としていたが、現実的な30〜40m先の人物の認識から行おうと思う。

OpenCVとdlibを用いた視線検出プログラムを動作させた。

目の検出はうまく行えているが、瞳を検出しない場合が多かった。また瞳を検出した時も視線が変な方向を示すことがあった。

- DL-Boxのデータ整理、自分のパソコンに研究データ(200GB)を移した。今後、外付けハードディスクに移す予定。

- DL-BoxでKerasを使えるように環境を構築した。(KerasのAPIが優秀なため)

Stay Hungry, Stay Foolish!