骨格とシルエットを入力としたモデルを作成するために、まず、骨格情報をもとに歩行者の推定を行いたい

そこで骨格を図のようなグラフとして入力できるGraph Convolution Networkを使用しようと考えました。

実際は動画なので、骨格の連続データで、https://github.com/yysijie/st-gcnを試そうと思いましたが、データ形式が分かっておらず苦戦しています。

大ゼミまでに進捗を出せるように何とか頑張ります

グラフ以外での骨格情報の処理方法の案をお聞きしたいです

骨格とシルエットを入力としたモデルを作成するために、まず、骨格情報をもとに歩行者の推定を行いたい

そこで骨格を図のようなグラフとして入力できるGraph Convolution Networkを使用しようと考えました。

実際は動画なので、骨格の連続データで、https://github.com/yysijie/st-gcnを試そうと思いましたが、データ形式が分かっておらず苦戦しています。

大ゼミまでに進捗を出せるように何とか頑張ります

グラフ以外での骨格情報の処理方法の案をお聞きしたいです

3Qの最終課題がやっと終わりましたーーーーー

転移学習させたが、精度が悪化した。重みを固定する層と各層の学習率の変更で改善に試みます。

Mobilenetは小さい物体の検出が難しいので、取得画像を2分割して処理するように変更。

20種類分の学習データの準備が間に合わなかったので急ぎ作成します。

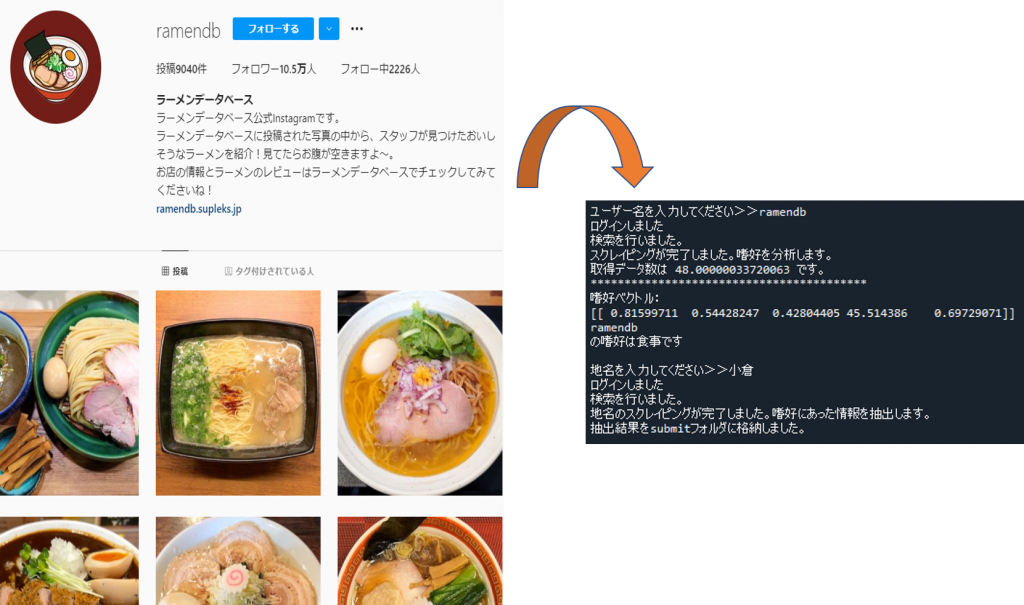

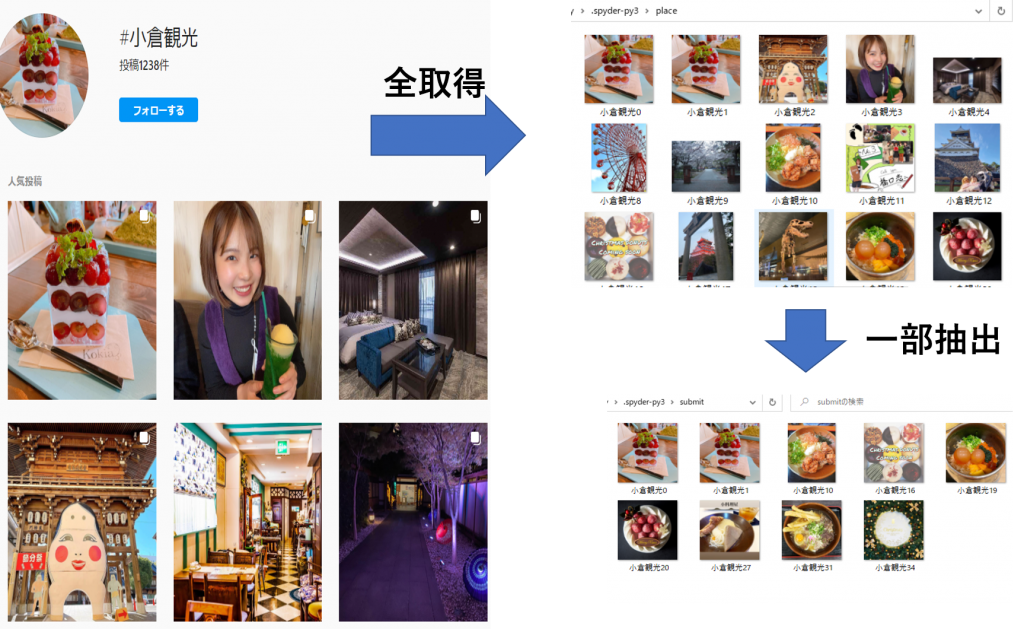

「ユーザーのSNS投稿に基づいた個人嗜好情報分類による高適合性情報提示システムの提案」

進捗

ユーザー名入力>>ユーザー嗜好判断>>地名入力>>ユーザーの嗜好にあった画像を抽出

する一連のプログラムを書いた。

嗜好分類、情報抽出ともに3秒ほどで行える。食事カテゴリーは分類がうまくいっている。

今は分類モデルをもう一度作成して精度向上に努めています。

アクティビティ... 人と動物、マリンスポーツ、山登りなど人を含む画像をメインに集める

街並み... 市街地の景観、昼と夜の写真も入れ込む。

自然...人が映っていない山や海、川の風景メイン。

食事... 和洋中、ケーキなど

その他... ファッション、文字投稿、動物のみの画像など

今週中には実験してみます。

現状できているところまでのアプリを実行した動画です。

最初は3画面構成と言っていたのですが、4画面構成となりました。

1画面目:買い物リスト入力画面

2画面目:撮影

3画面目:文字認識

4画面目:結果出力

[今後の予定]

マッチング部分を引き続き製作します。

進捗

・AROB論文作成

gitにpushしてるので添削してほしいです。

予定

・北海道ITS論文作成中

・全体ゼミスライド作成

三菱電機 ウェビナー参加

TOTO デザイン指向テスト 受験

AROB:

I almost have finished the experiments of my proposed work on AROB 2022. And I got some improvement on the work.

The proposed work tend to have some improvement on pedestrian detection accuracy.

And the total detection accuracy also improved a little … Continue Reading ››