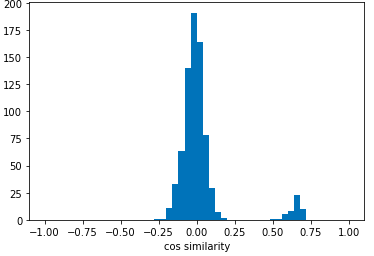

独自のデータセットでSTGCNとResNet3Dを用いて動画と骨格情報から得た特徴を結合して学習した。

K近傍法で100%分類できた。(最終的にはコサイン類似度で推論する予定)

TSNEで二次元に圧縮した結果

casia-b にRGB動画をダウンロードさせてもらうために連絡しましたが、新しい規則が出たらしくRGB動画はダウンロードできないそうです。白黒画像の白黒を逆にしてみると、白黒画像から骨格を取れました。(背景:、人物: 白 ー> 背景:白、人物: 黒)

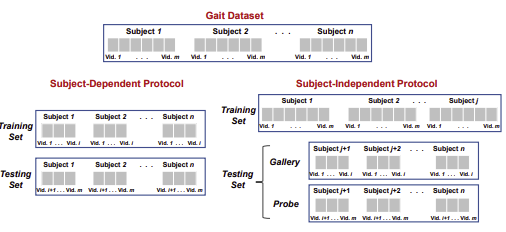

論文 をみてcasia-bのテスト方法を調べた

来週のゼミまでに

学習データをcasia-bにして精度を出す

・Tex Liveのインストール

・GIMPのインストール

・卒論執筆

CTC冬季インターンES提出

Yahoo本選考ES提出

LINE説明会参加

日鉄ソリューションズの選考に関して相談したいことがあります。

実験の結果、4*4のコードのみでの特定は近い距離で明確にならないと検出できませんでした

背景を含めて学習させ、かつ標識が通過する位置をトリミングした場合は15メートルほどでも検出可能です

ただ、4*4のコードそれぞれの区別はおそらくできないです(フィルムを張っていない場合でも検出されそうです)

背景と合わせて学習させることで、標識は確定できるので、埋め込める情報は減りますが2*2のコードとした場合はそれぞれを別のコードとして認識ができ、フィルムのない標識は検出しない(類似物体の検出抑制)ということができそうです。(試しに撮影した動画ではできそうです)

学内の実験ではとりあえず2*2のコードでデータを取ってみます。Jetsonでは推論は難しいですが、より入力画像のサイズが大きいモデルなら3*3くらいまでなら区別できないかなと思います。Jetsonのカメラがあまり性能よくなかったので、USBカメラを接続してみましたが、仕様の問題かフルHDでは映像が乱れ安定してない様子でした。実験はスマホで撮影して、その動画の推論をJetsonで行おうと思います。

最終的には、Jetsonでの車載では、20mの距離からの検出では2*2が現実的かなと思います。将来的な車載GPUの処理性能向上や高解像度のカメラが利用可能になることを踏まえれば3*3あるいは4*4のコードなどより多くの情報が埋め込み可能になるというところで修論の結論として書きたいと思います。

タイトル「買い物リストへの抽象的な入力に対応した買い忘れ防止システムの実装」

アプリは完成したので、現在実験を行っているところです。

[実験方法]

①収集したレシートに関する食品を100種類選び、番号をつけた食品のリストを作る。

②乱数メーカーというサイトを利用して、1から100までで、10個の乱数×2、15個の乱数×2、20個の乱数×2を取得し、①の食品リストと対応した番号の食品を抜き出し10品目×2、15品目×2、20品目×2の合計6つの購入予定リストを作る。

③②の6つのそれぞれの購入予定リストに合った疑似レシートを、収集したレシートを切り貼りして作成します。

④疑似レシートを用いて、アプリを試してみます。

現在、10品目×2・15品目×2までは終わっています。今日中に最後までやって、明日から修論を書きたいと思います。

・北海道学会論文作成中

・全体ゼミ(タイトル決め)のスライド作成中

・2月1日のタイトル締め切りって先生がみんなのタイトルを提出してくれるんでしたか?

・帰省していた井上さんと金とう先輩にご馳走になりました!!

・手で加速でセンサを動かし、擬似的に車が動いた状況を作った。途中でいっぱい振っているのは車がずっと動いている状況を作っている。それを止めると、画面にteishiの文字が出て再び動かすと再度顔認証される。

・二酸化炭素センサがなぜか動かず奮闘中。それを動かしている動画を撮れば一旦終わりにして論文書きます。

→ネットに書いている解決方法を全て試したが、いまだ動かず。

·論文を書いています。

·プログラム更新中です。

前処理では、データセットの各ビデオから20フレーム(以前は10フレーム)を選択して処理する。

Self-supervised training monocular depth prediction network under the instruction of a stronger network that trained on stereo image. The result shows that the accuracy can be improved, and the scale can be recovered.

About the question: network perform well on classification task while has no advantage in depth prediction task. I read some papers … Continue Reading ››

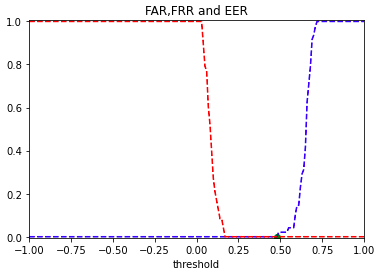

FAR, FRR, EERを求めた。

EERはcos類似度が0.17〜0.48で0%になった。

投稿ナビゲーション

Stay Hungry, Stay Foolish!