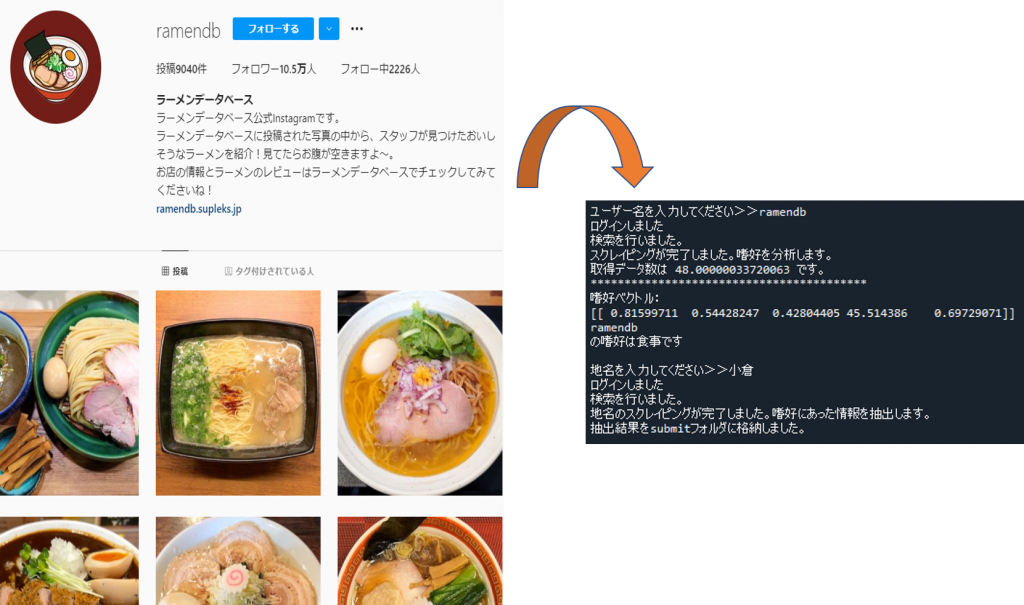

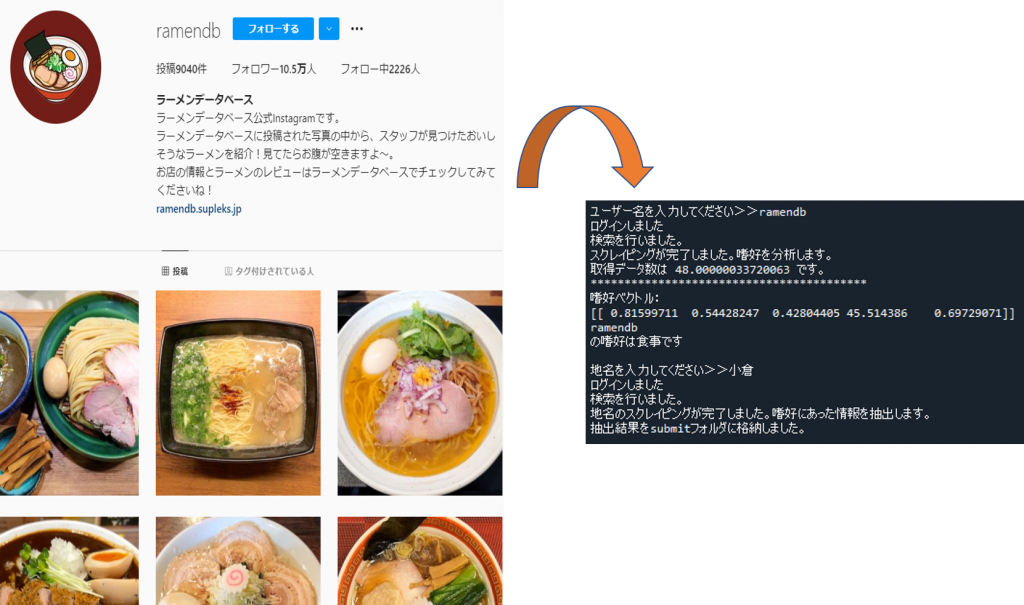

「ユーザーのSNS投稿に基づいた個人嗜好情報分類による高適合性情報提示システムの提案」

進捗

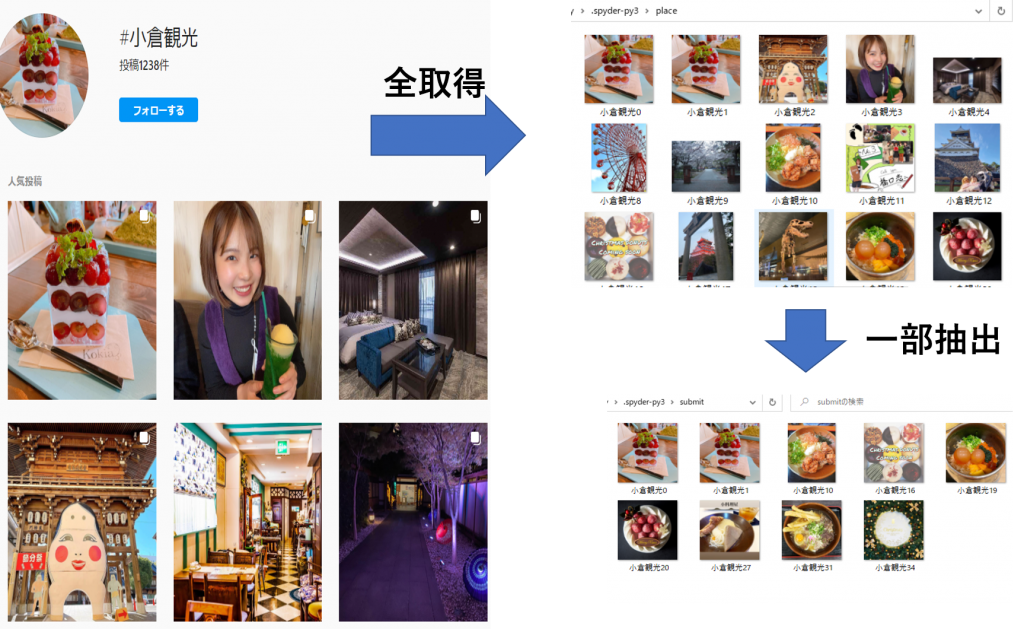

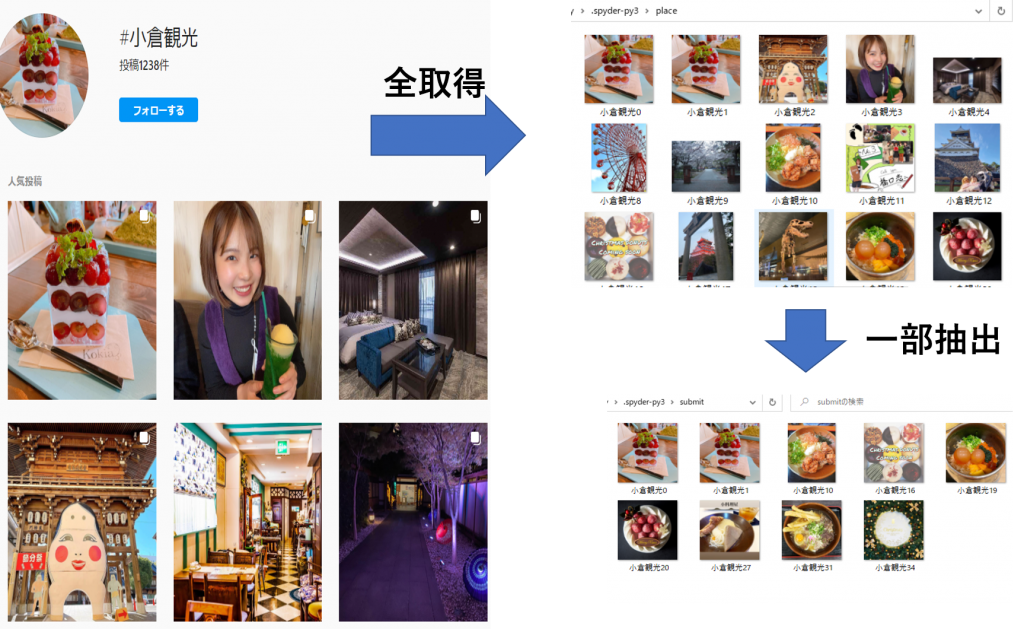

ユーザー名入力>>ユーザー嗜好判断>>地名入力>>ユーザーの嗜好にあった画像を抽出

する一連のプログラムを書いた。

嗜好分類、情報抽出ともに3秒ほどで行える。食事カテゴリーは分類がうまくいっている。

今は分類モデルをもう一度作成して精度向上に努めています。

アクティビティ... 人と動物、マリンスポーツ、山登りなど人を含む画像をメインに集める

街並み... 市街地の景観、昼と夜の写真も入れ込む。

自然...人が映っていない山や海、川の風景メイン。

食事... 和洋中、ケーキなど

その他... ファッション、文字投稿、動物のみの画像など

今週中には実験してみます。

現状できているところまでのアプリを実行した動画です。

最初は3画面構成と言っていたのですが、4画面構成となりました。

1画面目:買い物リスト入力画面

2画面目:撮影

3画面目:文字認識

4画面目:結果出力

[今後の予定]

マッチング部分を引き続き製作します。

進捗

・AROB論文作成

gitにpushしてるので添削してほしいです。

予定

・北海道ITS論文作成中

・全体ゼミスライド作成

・SAES:発表済み→12/30までにフルペーパー提出

・ITS;アブスト提出

・JIIAE:ジャーナル執筆

→gitにpushしているので時間があったら確認お願いします🙏

→芹川先生と張先生の写真が欲しいです😭

・今使っているMdk-ResNetの出力にArcFaceを組み込んで深層距離学習ができるようにした。閾値を決めて、設定した行動・所持位置以外の入力があった際に、弾けるようにプログラムを修正していく(今月の大ゼミまでに終わらせる)

・タスク(優先度高い順に)

深層距離学習用にプログラム作成(大ゼミ用資料作成)→AROBフルペーパー→SAESフルペーパー→北海道のフルペーパー

- QT-Net

- Taking source image for another 50 classes of items.

- To test the capacity of the network, doing experiments on the datasets with 90 classes.

- Making annotation for the test datasets with 90 classes, and test the model on it, the accuracy is 0.987 (IOU=0.75)

- Modified the output of the plot of BBox. For any item, … Continue Reading ››

・車座参加

・chainerからPyTorchに変更して、学習を行い、制度を求めた。

マスク無

Test set: Average loss: 0.0166, Accuracy: 2436/3589 (67.87%)

・すべてのデータセットにマスクをつける範囲を白く塗りつぶしている。

https://arxiv.org/pdf/2102.09546.pdf これを少し読んだ

研究の新規性を考えた

歩容認証はバッグを持ったり、コートを着たり、帽子をつけたりしたときの外見の変化に弱い。そこで外見の変化に強い歩容認証を行いたい

人物のシルエット+骨格の情報を入力としたモデルを作ろうと考えています

精度はRGBの場合とほとんど変わらなかった

- カメラ2台に対応したモデルを実装

- 先行研究の論文を読む

Two-Stream CNNs for Gesture-Based Verification and Identification: Learning User Style

https://www.cv-foundation.org/openaccess/content_cvpr_2016_workshops/w4/html/Wu_Two-Stream_CNNs_for_CVPR_2016_paper.html

概要

・ハンドジェスチャーを生体認証として利用するための研究

・ネットワークはTwo-Stream CNNsを使用し、ハンドジェスチャーのdepth map、optical flowから特徴量を抽出

・ImageNetの重みで初期化

・ユーザーが行う特定のジェスチャーだけでなく、ユーザーがジェスチャーを行う際の特定のスタイルを学習する

・ラズパイで今までパソコンで動かしてきたプログラムを動かすため、ラズパイに環境構築

→顔認証のプログラムを動かすだけで8秒かかるので、処理時間を短くする必要あり

・トリガーとなるセンサーのプログラム完成

→後は閾値を細かく決めてプログラムを引っ付けるだけ

Stay Hungry, Stay Foolish!